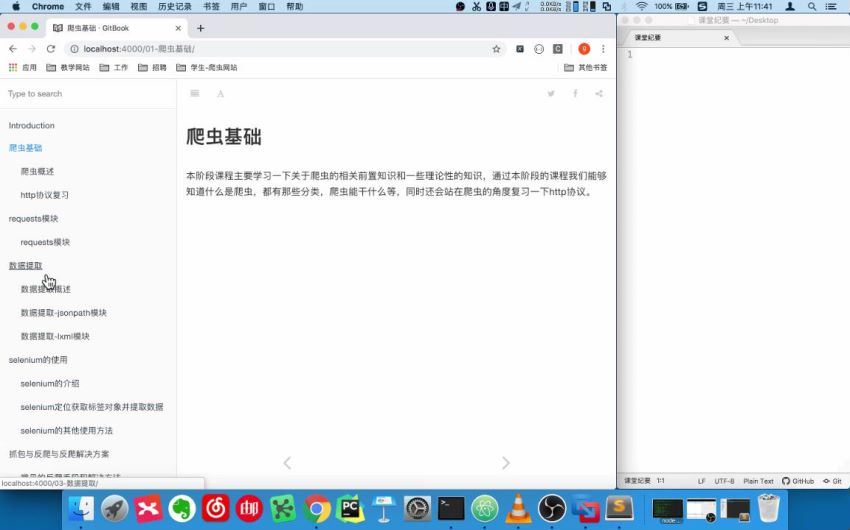

资料名称:Python爬虫 数据采集课程【完整资料】,总大小:11.75G,其中共包含564 个文件与视频资料,详见下方截图预览和文件目录,内容百度网盘分享。

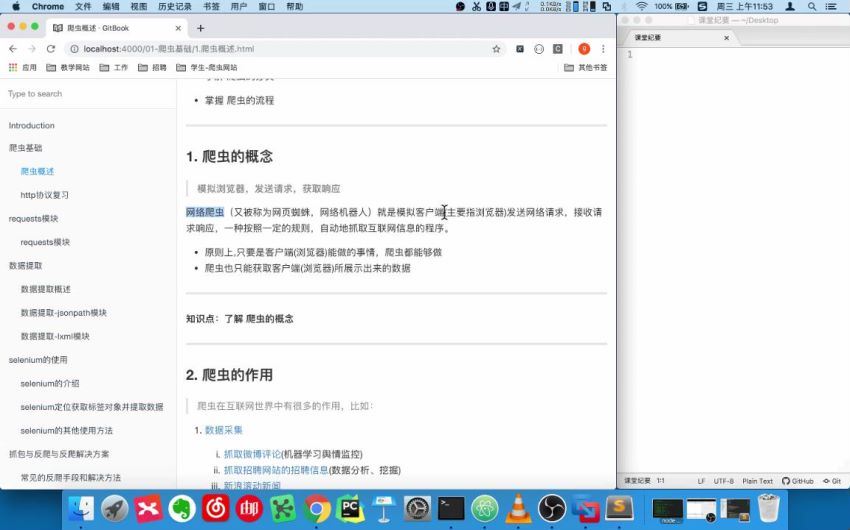

截图预览:

文件目录:

01_爬虫基础[789.75M]

01_爬虫基础[789.75M]

01.爬虫特点介绍.flv[35.35M]

02.课程结构.flv[12.74M]

03.爬虫的概念.flv[32.66M]

04.爬虫的作用.flv[178.67M]

05.爬虫的分类.flv[68.23M]

06.爬虫的流程.flv[46.18M]

07.http与https的区别.flv[27.64M]

08.常见的请求头与响应头.flv[164.32M]

09.创建的响应状态码.flv[75.57M]

10.浏览器运行过程.flv[148.39M]

02_requests模块[1.38G]

02_requests模块[1.38G]

1.requests模块-简介-安装-使用.flv[52.22M]

10.requests模块-代理proxies使用.flv[128.07M]

11.requests模块-verify参数与ca证书.flv[44.06M]

12.requests模块-post请求_金山翻译案例.flv[170.88M]

13.requests-post数据来源.flv[199.73M]

14.requests模块-session.flv[19.82M]

15.案例-github模拟登陆.flv[270.08M]

2.requests模块-响应对象的text与content之间的区别.flv[49.57M]

3.requests模块-响应对象常用的参数和方法.flv[39.53M]

4.requests模块-发送带请求头的请求.flv[92.94M]

5.requests模块-发送带参数的请求.flv[107.85M]

6.requests模块-在headers中设置cookies参数.flv[92.53M]

7.requests模块-cookies参数的使用.flv[89.58M]

8.requests模块-cookiejar对象的处理.flv[26.16M]

9.requests模块-timeout参数.flv[32.52M]

03_数据提取[1.26G]

03_数据提取[1.26G]

01.数据提取-响应内容的分类.flv[168.45M]

02.xml与html.flv[22.70M]

03.常用数据解析方法.flv[18.33M]

04.jsonpath-场景-安装-使用.flv[54.77M]

05.jsonpath-练习.flv[29.55M]

06.jsonpath-案例-拉钩.flv[35.99M]

07.lxml简介.flv[29.75M]

08.xpathhelper简介_安装.flv[64.40M]

09.xpath语法-基础节点选择.flv[149.41M]

10.xpath语法-节点修饰语法.flv[458.13M]

11.xpath语法-其他常用语法.flv[16.50M]

12.lxml使用.flv[137.21M]

13.百度贴吧.flv[90.71M]

14.tostring.flv[17.23M]

04_selenium[1.57G]

04_selenium[1.57G]

01.selenium-介绍_效果展示.flv[87.91M]

02.selenium的工作原理.flv[21.90M]

03.selenium-模块与driver的安装.flv[98.76M]

04.selenium-简单使用.flv[36.23M]

05.selenium-driver属性和方法.flv[27.54M]

06.selenium-元素定位.flv[184.14M]

07.selenium-元素操作.flv[54.51M]

08.selenium-标签切换.flv[111.81M]

09.selenium-窗口切换.flv[125.82M]

10.selenium-cookies操作.flv[64.44M]

11.selenium-执行js.flv[119.77M]

12.selenium-页面等待.flv[77.65M]

13.selenium-配置对象.flv[27.08M]

14.selenium-案例-斗鱼直播.flv[568.09M]

05_反爬与反反爬[1.32G]

05_反爬与反反爬[1.32G]

01.反爬与反反爬-反爬原因.flv[18.63M]

02.反爬与反反爬-什么样的爬虫会被反.flv[19.25M]

03.反爬与反反爬-常见概念与反爬方向.flv[26.80M]

04.反爬与反反爬-基于身份识别的反爬.flv[39.78M]

05.反爬与反反爬-及与爬虫行为的反爬.flv[120.16M]

06.反爬与反反爬-基于数据加密进行反爬.flv[130.21M]

07.验证码-验证码的知识.flv[27.34M]

08.验证码-图像识别引擎.flv[56.10M]

09.验证码-打码平台.flv[125.58M]

10.chrome浏览器的使用.flv[85.38M]

11.js解析-人人网登录分析.flv[74.38M]

12.js解析-定位js文件.flv[73.71M]

13.js解析-js代码分析.flv[93.38M]

14.js解析-js2py使用.flv[87.64M]

15.js解析-人人网登陆.flv[31.05M]

16.有道翻译分析.flv[93.40M]

17.hashlib使用.flv[120.98M]

18.有道翻译实现.flv[128.38M]

06_MongoDB数据库[505.78M]

06_MongoDB数据库[505.78M]

01.mongodb的介绍.flv[43.03M]

02.mongodb的安装.flv[38.24M]

03.mongodb简单使用-测试启动.flv[47.13M]

04.mongodb简单使用-生产启动.flv[91.64M]

05.mongodb简单使用-数据库操作.flv[7.88M]

06.mongdb简单使用-集合操作.flv[19.66M]

07.mongodb的数据类型.flv[12.74M]

08.mongdb插入数据.flv[16.25M]

09.mongodb查询数据.flv[26.28M]

10.mongodb查询结果操作.flv[19.83M]

11.mongodb-修改&删除.flv[29.66M]

12.聚合管道-分组管道.flv[29.74M]

13.聚合管道-其他管道.flv[30.12M]

14.mongodb-索引.flv[34.72M]

15.mongodb的权限管理-管理用户.flv[10.35M]

16.mongodb权限管理-普通用户.flv[13.70M]

17.pymongo使用.flv[34.81M]

07_scrapy基础[1.46G]

07_scrapy基础[1.46G]

01.scrapy-概念&作用.flv[6.43M]

02.scrapy-工作流程.flv[32.30M]

03.scrapy-各模块功能.flv[10.91M]

04.项目开发流程-1框架安装&流程简介.flv[3.86M]

05.项目开发流程-2创建项目.flv[8.92M]

06.项目开发流程-3创建爬虫.flv[25.12M]

07.项目开发流程-4完成爬虫.flv[61.85M]

08.项目开发流程-5保存数据.flv[122.59M]

09.项目开发流程-数据建模&流程完善.flv[22.04M]

10.请求对象-请求&网易招聘简介.flv[7.28M]

11.请求对象-案例-网易招聘.flv[55.80M]

12.请求对象-其他参数.flv[14.78M]

13.请求对象-meta传参.flv[29.64M]

14.scrapy模拟登陆-cookies参数使用.flv[31.44M]

15.scrapy模拟登陆-FormRequest发送post请求.flv[34.33M]

16.scrapy管道的使用.flv[64.80M]

17.crawlspider.flv[39.12M]

18.tencent_crawl.flv[55.13M]

19.中间件-分类与作用.flv[95.57M]

20.中间件-豆瓣爬虫.flv[169.93M]

21.中间件-随机请求头.flv[115.00M]

22.中间件-随机ip代理.flv[204.38M]

23.中间件-selenium动态加载.flv[282.67M]

08_scrapy-redis[2.07G]

08_scrapy-redis[2.07G]

01.scrapy-redis-分布式的概念_原理.flv[169.73M]

02.scrapy-redis-断点续爬.flv[243.31M]

03.scrapy-redis-源码分析.flv[342.33M]

04.scrapy-redis-分布式爬虫实现.flv[285.84M]

05.scrapy-redis-分布式爬虫编写流程.flv[38.27M]

06.scrapy-redis-京东爬虫-简介.flv[187.43M]

07.scrapy-redis-京东爬虫-图书分类页面.flv[199.00M]

08.scrapy-redis-京东爬虫-图书列表页面.flv[197.01M]

09.scrapy-redis-京东爬虫-图书价格.flv[216.34M]

10.scrapy-redis-京东爬虫-修改成分布式爬虫.flv[236.06M]

09_scrapy其他[804.00M]

09_scrapy其他[804.00M]

01.splash-介绍_环境配置.flv[111.77M]

02.splash-使用.flv[118.54M]

03.scrapy-日志信息.flv[142.72M]

04.scrpay配置-常用配置.flv[127.16M]

05.scrapy配置-其他配置.flv[69.76M]

06.使用scrapyd进行爬虫部署.flv[130.01M]

07.使用Gerapy进行爬虫管理.flv[104.04M]

10_appium[614.29M]

10_appium[614.29M]

01.appium简介.flv[48.25M]

02.appium环境搭建.flv[288.17M]

03.appium环境联调测试.flv[120.93M]

04.appium使用.flv[156.94M]

资料[47.04M]

第10节appium[3.29M]

1.课件[3.29M]

images[3.27M]

2.1.1.1安装node.js.png[73.87K]

2.1.2.1-安装java.jpg[106.87K]

2.1.2.2-安装java.jpg[49.12K]

2.1.2.3-安装java.jpg[25.69K]

2.1.2.4-安装java.jpg[41.89K]

2.1.2.5-安装java.jpg[40.05K]

2.1.2.6-安装java.jpg[57.25K]

2.1.2.7-安装java.png[30.24K]

2.1.2.8-安装java.png[61.75K]

2.1.3.1.jpg[51.06K]

2.1.3.10.jpg[8.86K]

2.1.3.11.jpg[42.63K]

2.1.3.12.jpg[36.55K]

2.1.3.13.jpg[63.13K]

2.1.3.14.jpg[60.97K]

2.1.3.15.jpg[48.33K]

2.1.3.2.jpg[25.88K]

2.1.3.3.jpg[35.64K]

2.1.3.4.jpg[36.19K]

2.1.3.5.jpg[33.81K]

2.1.3.6.jpg[105.76K]

2.1.3.7.jpg[29.05K]

2.1.3.8.jpg[48.14K]

2.1.3.9.jpg[42.56K]

2.1.4.1.jpg[41.78K]

2.1.4.2.jpg[25.65K]

2.1.4.3.jpg[25.94K]

2.1.5.1.jpg[45.90K]

2.1.5.2.jpg[60.79K]

2.1.5.3.jpg[21.20K]

2.1.5.4.jpg[54.44K]

2.2.1.1.png[85.40K]

2.2.1.2.png[121.38K]

2.2.2.1.png[13.60K]

2.2.3.1_.png[56.42K]

2.2.3.2_.png[27.12K]

2.2.3.3_.png[16.19K]

2.2.3.4_.png[63.52K]

2.2.3.5.png[150.62K]

2.2.3.6.png[76.83K]

2-3-2-appiumDesktop定位界面使用方法.jpg[42.36K]

android-sdk-manager更新.png[24.00K]

android-sdk-manager更新-2.png[50.19K]

appium-session配置.png[62.79K]

java-jdk1.8下载.png[149.61K]

元素定位.png[977.23K]

.DS_Store[6.00K]

1.appium环境安装.md[5.70K]

2.利用appium自动控制移动设备并提取数据.md[8.42K]

README.md[0.30K]

2.其他资料(空)[0.00K]

3.代码[3.58K]

douyin.py[3.58K]

第1节爬虫基础[733.09K]

1.课件[733.09K]

images[723.61K]

.DS_Store[6.00K]

content-type.webp[9.71K]

http的请求形式.png[61.49K]

http的响应形式.png[80.99K]

http发送的过程.png[211.39K]

http作用.png[96.06K]

爬虫的工作流程.png[87.95K]

爬虫分类.png[170.01K]

1.爬虫概述.md[3.46K]

2.http协议复习.md[5.74K]

README.md[0.27K]

2.其他资料(空)[0.00K]

3.代码(空)[0.00K]

第2节requests模块[2.31M]

1.课件[2.30M]

images[2.28M]

12306ssl错误.png[256.58K]

4-2-2-1.jpg[82.96K]

4-2-2-2.jpg[22.71K]

4-2-2-3.jpg[112.22K]

formdata.jpeg[20.88K]

king.jpeg[219.67K]

requests-3-2-1-4.png[194.32K]

requests-3-2-3.png[45.63K]

responsedata.jpeg[240.34K]

百度翻译移动版-1.png[240.86K]

百度翻译移动版-2.png[169.31K]

百度翻译移动版-3.png[174.03K]

百度翻译移动版-4.png[161.37K]

查看移动端页面.png[293.66K]

使用代理的过程.png[100.35K]

README.md[0.42K]

requests模块.md[22.64K]

2.其他资料(空)[0.00K]

3.代码[7.40K]

1.easy_requersts.py[0.61K]

10.king.py[1.17K]

11.requests_session.py[0.67K]

2.reqeusts_headers.py[0.45K]

3.zhihu.py[0.39K]

4.requests_params.py[0.73K]

5.requests_headers_cookies.py[1.02K]

6.requests_cookies.py[1.25K]

7.requests_cookies.py[0.57K]

8.reqeusts_proxy.py[0.40K]

9.ca.py[0.15K]

第3节数据提取[2.22M]

1.课件[2.21M]

images[2.19M]

jsonpath的方法.png[148.93K]

jsonpath使用示例.png[33.04K]

xml和html的区别.png[93.36K]

xml树结构.gif[3.76K]

xpath_helper插件安装-1.png[87.49K]

xpath_helper插件安装-2.png[46.27K]

xpath_helper插件安装-3.png[353.12K]

xpath中节点的关系.png[244.30K]

非结构化响应内容html.png[457.69K]

节点.png[136.31K]

结构化响应内容json.png[477.69K]

数据解析.png[164.29K]

1.数据提取概述.md[3.00K]

2.数据提取-jsonpath模块.md[2.84K]

3.数据提取-lxml模块.md[12.54K]

README.md[0.26K]

2.其他资料(空)[0.00K]

3.代码[5.32K]

5.jsonpath_test.py[0.34K]

6.path_test.py[0.88K]

8.lxml_text.py[1.26K]

9.teiba.py[2.46K]

lagou.py[0.39K]

第4节selenium[2.69M]

1.课件[508.58K]

images[487.69K]

selenium的工作原理.png[22.48K]

查看chrome版本.png[75.83K]

查看chrome版本2.png[46.82K]

下载chromedriver-1.png[129.67K]

下载chromedriver-2.png[72.65K]

下载chromedriver-3.png[66.08K]

下载chromedriver-4.png[74.15K]

1.selenium的介绍.md[5.84K]

2.selenium定位获取标签对象并提取数据.md[3.16K]

3.selenium的其它使用方法.md[11.62K]

README.md[0.28K]

2.其他资料(空)[2.18M]

浏览器插件[2.18M]

MacOSX[1.09M]

JSONView0.0.32.2_0.crx[94.08K]

SwitchyOmega-2.3.21.crx[777.91K]

XPath-Helper_v2.0.2.crx[246.57K]

Windows[1.09M]

JSONView0.0.32.2_0.crx[94.08K]

SwitchyOmega-2.3.21.crx[777.91K]

XPath-Helper_v2.0.2.crx[246.57K]

3.代码[7.42K]

1.example_test.py[0.98K]

10.wait.py[0.20K]

11.selenium_config.py[0.59K]

12.douyu.py[1.68K]

2.selenium_test.py[0.38K]

3.selenium_attribute&func.py[0.47K]

4.locate_test.py[0.85K]

5.58.py[0.54K]

6.window_handler.py[0.78K]

7.qzone.py[0.47K]

8.selenium_cookies.py[0.23K]

9.execute_js.py[0.25K]

第5节反爬与反反爬[3.41M]

1.课件[3.40M]

images[3.37M]

chrome中network更多用途.png[108.11K]

js的绑定事件.png[303.47K]

searchallfile搜索关键字.png[373.29K]

点击美化输出.png[68.15K]

勾选perservelog的效果.png[224.52K]

继续在其中搜索关键字.png[109.64K]

人人网登录的地址.png[254.61K]

人人网手机版登录.png[292.05K]

人人网抓包寻找url地址.png[305.69K]

使用字体来反爬.png[706.72K]

添加断点.png[386.78K]

通过css反爬.png[226.41K]

新建隐身窗口.png[87.85K]

1.常见的反爬手段和解决方法.md[10.80K]

2.打码平台的使用.md[9.72K]

3.chrome在爬虫中的使用.md[3.37K]

4.JS的解析.md[7.87K]

README.md[0.08K]

2.其他资料(空)[0.00K]

3.代码[9.48K]

1.pytessseract.py[0.17K]

YDMHTTPDemo3.x.py[4.63K]

yundama.py[4.69K]

第6节MongoDB数据库[595.28K]

1.课件[594.45K]

images[562.95K]

4.3.创建索引速度对比.png[198.30K]

7.mongodb总结.png[175.69K]

mongodb的聚合.png[188.96K]

1.mongodb介绍和安装.md[2.97K]

2.mongodb的简单使用.md[4.44K]

3.mongodb的增删改查.md[5.89K]

4.mongodb的聚合操作.md[7.09K]

5.mongodb的索引操作.md[3.10K]

6.mongodb的权限管理.md[2.98K]

7.mongodb和python交互.md[4.45K]

8.mongodb总结图.md[0.06K]

README.md[0.51K]

2.其他资料(空)[0.00K]

3.代码[0.83K]

1.pymongo_test.py[0.83K]

第7节scrapy基础[7.24M]

1.课件[6.23M]

images[6.15M]

.DS_Store[6.00K]

0.jpg[28.12K]

1.3.1.爬虫流程-1.png[66.62K]

1.3.2.爬虫流程-2.png[101.56K]

1.3.3.scrapy工作流程.png[217.80K]

1.3.4.scrapy组件.png[340.79K]

10.1.scrapy_debug.png[347.62K]

11.scrapyd-1.jpg[128.38K]

11.scrapyd-2.jpg[42.00K]

11.scrapyd-3.jpg[49.95K]

11.scrapyd-4.jpg[61.67K]

11.scrapyd-5.jpg[62.47K]

11.scrapyd-6.jpg[53.08K]

11.scrapyd-7.jpg[106.92K]

12.scrapy总结图.png[528.16K]

2.1.scrapy入门使用-1.png[155.44K]

2.2.scrapy入门使用-2.png[188.52K]

3.1.scrapy翻页.png[13.46K]

4.3.1request-payload.jpg[8.34K]

7.4.2.scrapy_redis的流程.png[374.25K]

8.3.domz运行现象.png[415.17K]

8.4.1.redis_pipeline.png[163.34K]

8.4.2.RFP.png[385.96K]

8.4.3.scheduler.png[293.35K]

9.3.1.3.splash-server.png[86.62K]

9.4.5.2.no-splash.png[39.60K]

9.4.5.2.with-splash.png[88.64K]

build之后.png[263.43K]

gerapy_列表.png[37.16K]

gerapy_目录结构.png[25.09K]

gerapy_配置scrapyd服务器.png[33.20K]

gerapy_数据库初始化.png[322.63K]

gerapy_调度scrapy爬虫项目.png[41.18K]

gerapy_主机管理页面.png[79.98K]

gerapy_主机管理页面_添加.png[85.52K]

gerapy_主机添加.png[25.48K]

gerapy_主界面.png[33.44K]

project_1.png[26.49K]

project_list.png[92.83K]

project项目打包.png[252.98K]

部署.png[228.50K]

部署成功.png[164.78K]

运行1.png[92.45K]

运行2.png[140.17K]

1.scrapy的概念作用和工作流程.md[3.49K]

10.scrapy的日志信息与配置.md[6.86K]

11.scrapyd部署scrapy项目.md[3.34K]

12.gerapy爬虫管理.md[3.96K]

13.gerapy爬虫管理.md[3.83K]

13.scrapy总结图.md[0.06K]

14.crawlspider类的使用.md[5.28K]

2.scrapy的入门使用.md[7.02K]

3.scrapy构造并发送请求.md[8.65K]

4.scrapy模拟登陆.md[5.12K]

5.scrapy管道的使用.md[4.11K]

6.scrapy中间件的使用.md[8.71K]

7.scrapy_redis概念作用和流程.md[1.99K]

8.scrapy_redis原理分析并实现断点续爬以及分布式爬虫.md[6.38K]

9.scrapy_splash组件的使用.md[6.23K]

README.md[0.64K]

2.其他资料(空)[0.00K]

3.代码[1.01M]

AQI[18.04K]

AQI[17.80K]

__pycache__[1.76K]

__init__.cpython-36.pyc[0.14K]

items.cpython-36.pyc[0.50K]

middlewares.cpython-36.pyc[0.81K]

settings.cpython-36.pyc[0.31K]

spiders[7.45K]

__pycache__[2.00K]

__init__.cpython-36.pyc[0.14K]

aqi.cpython-36.pyc[1.86K]

__init__.py[0.16K]

__init__.pyc[0.14K]

aqi.py[2.48K]

aqi.pyc[2.67K]

__init__.py[0.00K]

__init__.pyc[0.13K]

items.py[0.61K]

items.pyc[0.64K]

middlewares.py[0.70K]

middlewares.pyc[2.50K]

pipelines.py[0.28K]

settings.py[3.08K]

settings.pyc[0.65K]

scrapy.cfg[0.24K]

Douban[12.26K]

Douban[12.01K]

__pycache__[3.52K]

__init__.cpython-36.pyc[0.14K]

items.cpython-36.pyc[0.34K]

middlewares.cpython-36.pyc[1.15K]

settings.cpython-36.pyc[1.89K]

spiders[2.10K]

__pycache__[1.13K]

__init__.cpython-36.pyc[0.15K]

movie.cpython-36.pyc[0.98K]

__init__.py[0.16K]

movie.py[0.81K]

__init__.py[0.00K]

items.py[0.28K]

middlewares.py[1.13K]

pipelines.py[0.28K]

settings.py[4.70K]

scrapy.cfg[0.25K]

github[493.98K]

github[14.54K]

__pycache__[0.38K]

__init__.cpython-36.pyc[0.14K]

settings.cpython-36.pyc[0.24K]

spiders[8.67K]

__pycache__[4.52K]

__init__.cpython-36.pyc[0.15K]

git1.cpython-36.pyc[1.81K]

git2.cpython-36.pyc[1.45K]

git3.cpython-36.pyc[1.11K]

__init__.py[0.16K]

git1.py[1.30K]

git2.py[1.34K]

git3.py[1.36K]

__init__.py[0.00K]

items.py[0.28K]

middlewares.py[1.86K]

pipelines.py[0.28K]

settings.py[3.07K]

git_with_cookies.html[126.47K]

git_with_fromresponse.html[126.81K]

git_with_post.html[126.79K]

git_without_cookies.html[99.11K]

scrapy.cfg[0.25K]

myspider[415.10K]

myspider[9.43K]

__pycache__[1.71K]

__init__.cpython-36.pyc[0.14K]

items.cpython-36.pyc[0.38K]

pipelines.cpython-36.pyc[0.87K]

settings.cpython-36.pyc[0.32K]

spiders[3.39K]

__pycache__[1.04K]

__init__.cpython-36.pyc[0.15K]

itcast.cpython-36.pyc[0.89K]

__init__.py[0.16K]

itcast.py[2.19K]

__init__.py[0.00K]

items.py[0.33K]

middlewares.py[0.19K]

pipelines.py[0.69K]

settings.py[3.12K]

itcast.json[96.20K]

itcast1.html[154.61K]

itcast2.html[154.61K]

scrapy.cfg[0.25K]

wangyi[97.06K]

wangyi[22.05K]

__pycache__[3.74K]

__init__.cpython-36.pyc[0.16K]

items.cpython-36.pyc[0.78K]

pipelines.cpython-36.pyc[2.39K]

settings.cpython-36.pyc[0.41K]

spiders[10.92K]

__pycache__[4.60K]

__init__.cpython-36.pyc[0.17K]

job.cpython-36.pyc[1.74K]

job_crawl.cpython-36.pyc[1.33K]

job_simple.cpython-36.pyc[1.36K]

__init__.py[0.16K]

job.py[2.47K]

job_crawl.py[1.70K]

job_simple.py[2.00K]

__init__.py[0.00K]

items.py[0.81K]

middlewares.py[1.86K]

pipelines.py[1.58K]

settings.py[3.14K]

scrapy.cfg[0.25K]

wangyi.json[54.28K]

wangyi_simple.json[20.48K]

第8节scrapy-redis[121.42K]

1.课件[0.00K]

课件在第7节里.txt[0.00K]

2.其他资料(空)[0.00K]

3.代码[121.42K]

JD[14.38K]

JD[14.14K]

__pycache__[1.16K]

__init__.cpython-36.pyc[0.13K]

items.cpython-36.pyc[0.49K]

settings.cpython-36.pyc[0.54K]

spiders[5.93K]

__pycache__[2.51K]

__init__.cpython-36.pyc[0.14K]

book.cpython-36.pyc[2.37K]

__init__.py[0.16K]

book.py[3.26K]

__init__.py[0.00K]

items.py[0.50K]

middlewares.py[1.86K]

pipelines.py[0.28K]

settings.py[4.42K]

scrapy.cfg[0.24K]

scrapy-redis[107.03K]

docs[23.96K]

authors.rst[0.03K]

conf.py[8.17K]

contributing.rst[0.03K]

history.rst[0.03K]

index.rst[0.46K]

installation.rst[1.01K]

make.bat[6.32K]

Makefile[6.63K]

modules.rst[0.07K]

readme.rst[0.03K]

requirements.txt[0.09K]

scrapy_redis.rst[1.10K]

example-project[14.29K]

example[9.38K]

__pycache__[1.36K]

__init__.cpython-36.pyc[0.16K]

pipelines.cpython-36.pyc[0.55K]

settings.cpython-36.pyc[0.64K]

spiders[5.83K]

__pycache__[3.36K]

__init__.cpython-36.pyc[0.17K]

dmoz.cpython-36.pyc[1.06K]

mycrawler_redis.cpython-36.pyc[1.17K]

myspider_redis.cpython-36.pyc[0.96K]

__init__.py[0.24K]

dmoz.py[0.77K]

mycrawler_redis.py[0.85K]

myspider_redis.py[0.60K]

__init__.py[0.00K]

items.py[0.60K]

pipelines.py[0.35K]

settings.py[1.24K]

docker-compose.yml[0.14K]

Dockerfile[0.10K]

process_items.py[2.87K]

README.rst[1.54K]

requirements.txt[0.02K]

scrapy.cfg[0.24K]

src[26.42K]

scrapy_redis[26.42K]

__init__.py[0.19K]

connection.py[2.25K]

defaults.py[0.62K]

dupefilter.py[4.29K]

picklecompat.py[0.24K]

pipelines.py[2.03K]

queue.py[4.32K]

scheduler.py[5.63K]

spiders.py[6.67K]

utils.py[0.19K]

tests[20.35K]

test_connection.py[2.14K]

test_dupefilter.py[2.61K]

test_package_import.py[0.15K]

test_picklecompat.py[0.53K]

test_queue.py[1.19K]

test_scrapy_redis.py[8.88K]

test_spiders.py[4.64K]

test_utils.py[0.21K]

AUTHORS.rst[0.16K]

CONTRIBUTING.rst[3.16K]

HISTORY.rst[2.55K]

LICENSE[1.04K]

Makefile[3.99K]

MANIFEST.in[0.22K]

pytest.ini[0.15K]

README.rst[7.16K]

requirements-dev.txt[0.14K]

requirements-install.txt[0.09K]

requirements-setup.txt[0.10K]

requirements-tests.txt[0.08K]

setup.cfg[0.07K]

setup.py[1.74K]

TODO.rst[0.75K]

tox.ini[0.60K]

VERSION[0.01K]

第9节scrapy其他[1.71M]

1.课件[0.00K]

课件在第7节里.txt[0.00K]

2.其他资料(空)[0.00K]

3.代码[1.71M]

deploy[1.23M]

dbs[8.00K]

Tencent.db[8.00K]

eggs[12.40K]

Tencent[12.40K]

1554868409.egg[12.40K]

logs[706.96K]

Tencent[706.96K]

tencent[706.96K]

tencentpro[699.84K]

a6785c685b4411e9b320186590e02601.log[699.84K]

88b639ac5b4411e9ae2d186590e02601.log[7.12K]

py21.log[0.63K]

tencent.json[3.01K]

tencentpro.json[532.20K]

Splash[490.19K]

Splash[9.47K]

__pycache__[0.75K]

__init__.cpython-36.pyc[0.14K]

settings.cpython-36.pyc[0.61K]

spiders[2.76K]

__pycache__[1.72K]

__init__.cpython-36.pyc[0.15K]

baidu.cpython-36.pyc[0.62K]

baidu_ws.cpython-36.pyc[0.95K]

__init__.py[0.16K]

baidu.py[0.29K]

baidu_ws.py[0.60K]

__init__.py[0.00K]

items.py[0.28K]

middlewares.py[1.86K]

pipelines.py[0.28K]

settings.py[3.54K]

baidu.html[0.22K]

baidu_with_splash.html[480.25K]

scrapy.cfg[0.25K]

爬虫课件完整版本(HTML版本).zip[22.76M]

评论0